1 引言

网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难.

近年来,有研究表明端到端网络性能数据具有隐藏的时空相关性[10 ] ,提出了稀疏网络测量技术.稀疏网络测量技术基于采样的方式降低测量代价,仅测量部分路径和时隙的数据,推测全部数据,将网络测量问题转换成从部分测量值估计全部测量值的数据恢复问题.目前主要有3种典型的稀疏重构技术:压缩传感、矩阵填充和张量填充.作为一维向量和二维矩阵的高阶推广,张量模型可以充分利用多线性结构,挖掘高维数据之间隐藏的内在联系,达到更好的数据恢复精度.尽管前景光明,现有的张量填充算法针对网络性能数据恢复的研究现状仍然具有很大局限性,具体表现在其算法只考虑了单个网络性能指标的数据恢复,忽略了多个网络测量指标的关联信息.

实际的网络监控系统通常会涉及多个网络性能指标的测量,包括吞吐量、往返时延、丢包率等.有些指标的测量开销比较小,如测量往返时延只需要在源端记录探测数据包发送和到达的时刻,并计算时间戳之间的差值即可.现有的稀疏测量技术没有考虑多指标测量的应用场景,为了保证数据恢复的准确性仍然需要一定比例的吞吐量测量值,为网络带来较大的负担.由于网络中存在低测量开销的指标,同时考虑多个指标间的关系和测量代价,利用低开销的指标推测高开销的指标能够减少高开销指标的测量数量,进一步降低网络测量代价.此外,稀疏测量技术对单个指标在进行数据恢复时忽略了其他测量指标带来的附加信息,考虑到不同的指标之间具有相关性,在利用时空相关性进行稀疏重构的同时加入其他测量指标的外部辅助信息可以提高恢复精度.

基于上述思路,本文提出了一个面向大规模网络测量的数据恢复算法——基于关联学习的张量填充(Association Learning based Tensor Completion,ALTC).在多指标联合测量背景下,构建从低测量开销指标到高测量开销指标的关联模型,在高开销指标吞吐量数据极少的情况下,尽可能测量低开销指标往返时延,借助关联模型从往返时延推测吞吐量,降低网络测量代价.在传统张量填充的框架中加入多指标关联信息,同时挖掘吞吐量内部的时空相关性和外部关联模型的辅助信息,进一步提高数据恢复精度.本文主要贡献总结如下:

(1)对真实网络数据集进行实验验证,分析了吞吐量与往返时延之间的关联,发现它们之间相关性强,但是关系复杂,难以用普通线性函数建模.针对该挑战,设计了一个基于神经网络的吞吐量-往返时延关联学习模型,捕获两个指标之间的关联,使用低开销的往返时延推测高开销的吞吐量,降低网络测量代价.

(2)由于吞吐量测量数据的内部也具有潜在的时空相关性,可以通过张量填充算法从部分测量推测全部数据.为了同时利用内部时空相关性和其他指标的外部辅助信息,使用关联学习模型的推测值对吞吐量的测量值进行预填充,并设计一个新的张量填充模型,同时拟合吞吐量的测量值和关联模型的推测值,设置关键参数误差平衡权重控制模型对测量值和对推测值的拟合程度,提高数据恢复精度.

(3)真实数据集上的实验结果展示了所提算法ALTC在同样的吞吐量测量代价下可以显著提高数据恢复的精度.在采样率为2%的极低情况下,ALTC的恢复误差在传统线性张量填充算法的结果上改善了1.5倍,比目前主流的神经网络张量填充算法的误差降低了13%.

2 相关工作

从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进.

近年来有大量基于张量填充的网络数据恢复研究.Xie等人[15 ] 寻找数据的更强局部相关性来形成和填充更低秩的子张量,恢复网络流量数据.Deng等人[16 ] 提出了一种基于杠杆分数采样的自适应张量填充方案估计个人设备网络的延迟数据.Wang等人[17 ] 考虑网络数据中的噪声和异常,将L 2,1 范数和LF 范数引入张量填充模型中,估计网络流量.Xie等人[18 ] 基于Expectile回归对张量填充不同数据点的拟合误差设置两种不同的权重,提高大象流的恢复精度.除了这些基于CP分解或者Tucker分解的线性张量填充模型,Xie等人[19 ] 使用神经网络模型扩展传统张量填充算法的交互函数恢复网络监测数据,取得了很好的恢复精度.

然而,上述所有的模型或算法全都仅考虑单个网络性能指标,忽略了多个网络性能指标之间的关联,不仅数据恢复的精度受限,测量代价仍然很高.不同于现有研究,本文认为同时考虑多个网络性能指标的测量指标,多测量低开销指标、少测量高开销指标,挖掘指标之间的关联,利用低开销的指标辅助高开销的指标进行填充,同时使用数据内部的时空信息和指标外部的辅助信息,可以降低测量代价并提高数据恢复的精度.

3 问题建模和整体框架

3.1 问题建模

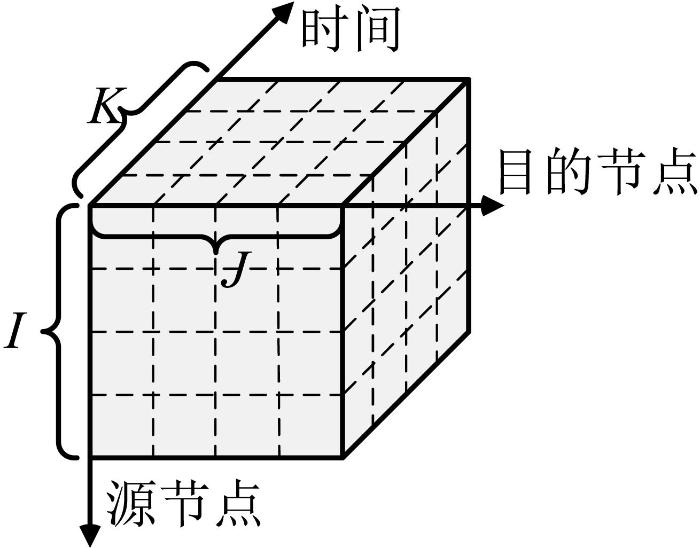

张量是高维数组,数组的维数又称为张量的模或者阶.如图1 所示,本文将网络测量数据建模成I × J × K I J K 𝒳 x i j k i j k 𝒴 y i j k i j k i j k 𝒳 𝒴

图1

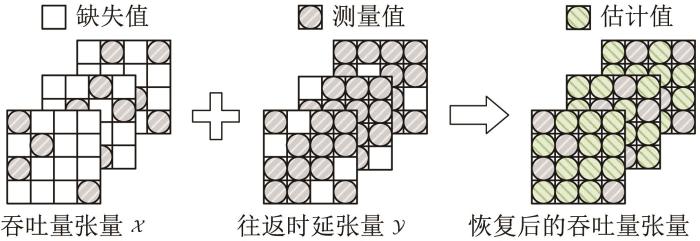

由于吞吐量的测量代价大,𝒳 Ω 𝒳 Ω ¯ x i j k ( i , j , k ) ∈ Ω ( i , j , k ) ∈ Ω ¯ . 由于往返时延的测量方式简单,𝒴 图2 所示,给定稀疏测量的吞吐量张量𝒳 Ω 𝒴 𝒳 𝒴 𝒳

图2

3.2 整体框架

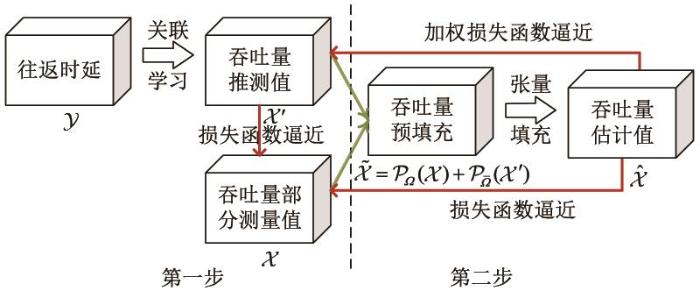

为了充分利用多个网络性能指标之间的关联达到更高的吞吐量数据恢复精度和更低的测量代价,本文提出了一个面向大规模网络测量的数据恢复算法,即基于关联学习的张量填充(ALTC).整体框架如图3 所示,首先研究了真实数据集中吞吐量与往返时延之间的关联,设计了一个使用往返时延推测吞吐量的神经网络关联学习模型(𝒴 → 𝒳 ' 𝒳 , 𝒳 ' → 𝒳 ˜ 𝒳 ˜ → 𝒳 ̂

图3

4 基于关联学习的张量填充算法

4.1 吞吐量与往返时延的关联

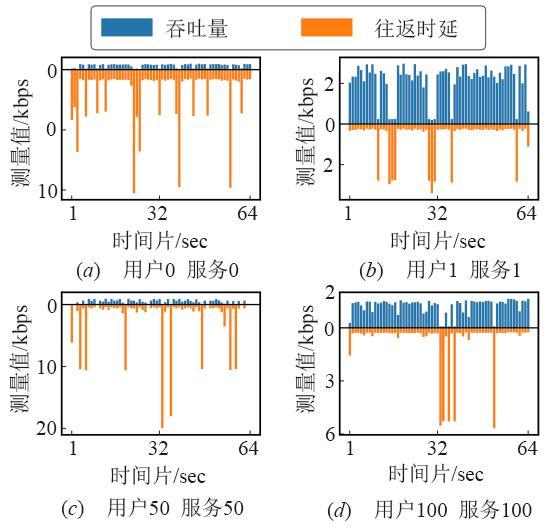

为了研究吞吐量与往返时间之间的关联模型,本文首先对真实网络数据集进行实验验证,分析吞吐量与往返时延之间的关联.WS-DREAM[23 ] 数据集记录了142个用户在64个连续时间片(以15分钟为间隔)上的4 500个Web服务的服务质量测量结果,包括了吞吐量和往返时延.随机选取了数据集中的若干个源目的(即用户-服务)节点对,并绘制了其中4组源目的节点对沿着64个时间片的测量值大小.如图4 所示,横坐标为时间片的索引,纵坐标为测量值的大小,0轴的上方为吞吐量大小,0轴的下方为往返时延大小.图片显示当吞吐量持平时,往返时延也相对稳定;当吞吐量较大时,往返时延相对较小;当吞吐量较小时,往返时延相对较大.尤其当吞吐量极小时,往返时延很大,可能是由于发生了拥塞.

图4

由此可知,同一网络结构下的吞吐量与往返时延之间存在强相关性,而且大体上成负相关.然而,由于在实际网络中不同的用户或服务具有不同的属性特征,难以使用简单的线性模型直接建模复杂的吞吐量和往返时延关系.这种复杂关系直观地表现在节点行为复杂,如两个具有相同大小的吞吐量源目的节点对的往返时延不一定相同.

4.2 吞吐量- 往返时延关联学习模型

学习吞吐量与往返时延之间的复杂关系、从往返时延推测吞吐量的任务,直觉上类似于自然语言处理中的机器翻译,可以看作是序列到序列的问题,应用编码-解码(Encoder-Decoder)模型求解,即输入往返时延序列,输出对应的吞吐量序列.然而由于数据是部分缺失的,无论是提取吞吐量张量的切片矩阵还是纤维向量,都无法形成完整的吞吐量序列,使得编码-解码模型难以训练,推测精度不高.

根据3.2节的分析,给定源节点i j k x i j k y i j k . 然而,仅通过点对点的关系建模吞吐量与往返时延之间的复杂关联存在2个局限性:(1)无法利用上下文信息,具体包括同一个源-目的节点对的测量值在不同时刻的变化以及同一时刻下不同源节点或目的节点类型对测量值的影响;(2)对异常和噪声敏感,当网络发生异常时会导致时延发生抖动,进一步导致对应吞吐量的预测值误差大.

在张量建模下,对于往返时延张量𝒴 y i j k i j k y : j k ∈ R I × 1 y i : k ∈ R J × 1 y i j : ∈ R K × 1 [24 ] .这3个向量在张量𝒴 y i j k y : j k y i : k y i j :

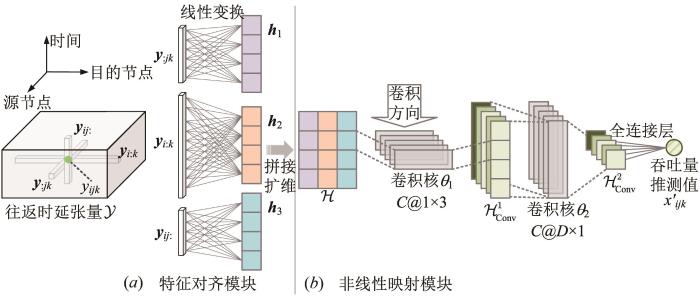

基于以上分析,为了准确地建立吞吐量与往返时延之间的关联,通过往返时延推测吞吐量,本文设计了一个吞吐量-往返时延关联学习模型(Association Learning Model,ALM),提出了从纤维到元素(fibers to element)的推测框架.如图5 所示,给定源节点-目的节点-时间三元组( i , j , k ) y : j k y i : k y i j : y : j k y i : k y i j : x i j k .

图5

图5

吞吐量-往返时延关联学习模型(图中例子:特征维度D =4,卷积通道数C =5)

在特征对齐模块中,y : j k y i : k y i j :

h 1 = W 1 T y : j k + b 1 h 2 = W 2 T y i : k + b 2 h 3 = W 3 T y i j : + b 3 (1)

其中,h 1 , h 2 , h 3 ∈ R D × 1 y : j k y i : k y i j : W 1 ∈ R I × D , W 2 ∈ R J × D ,

W 3 ∈ R K × D b 1 , b 2 , b 3 ∈ R D × 1 D h 1 , h 2 , h 3 ℋ . ℋ y i j k x i j k .

ℋ = e x p a n d _ d i m s h 1 , h 2 , h 3 ∈ R 1 × D × 3 (2)

非线性映射模块由2个二维卷积层和1个全连接层组成.第一层卷积核的大小为1 × 3 D × 1 . 令C θ 1 θ 2 R e L U ( ⋅ ) = m a x ( ⋅ , 0 )

ℋ C o n v 1 = R e L U C o n v ℋ ; θ 1 ∈ R C × D × 1 ℋ C o n v 2 = R e L U C o n v ℋ C o n v 1 ; θ 2 ∈ R C × 1 × 1 (3)

最后对ℋ C o n v 2 x i j k ' w ∈ R C × 1 b ∈ R σ ( ⋅ )

h = s q u e e z e ℋ C o n v 2 ∈ R C × 1 x i j k ' = σ w T h + b (4)

令x i j k ' = f y : j k , y i : k , y i j : | Θ 1)~(4)的吞吐量-往返时延关联学习模型,其中,Θ = W 1 , W 2 , W 3 , b 1 ,

b 2 , b 3 , θ 1 , θ 2 , w , b

m i n Θ 1 Ω ∑ ( i , j , k ) ∈ Ω x i j k - f y : j k , y i : k , y i j : | Θ 2 (5)

其中,Ω Ω 式(5),所有测量元素x i j k ( i , j , k ) ∈ Ω ( i , j , k ) ∈ Ω ¯ 𝒴 x i j k ' = f y : j k , y i : k , y i j : | Θ 𝒳 ' .

4.3 基于关联学习的张量填充算法

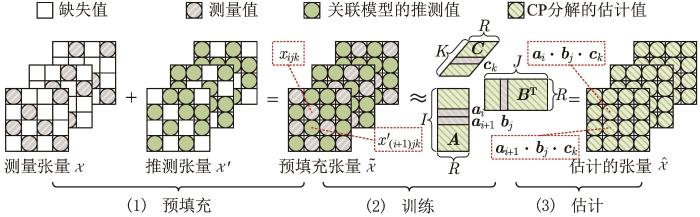

在学习了往返时延和吞吐量之间的关联之后,如何有效地结合关联学习模型与张量填充算法,同时利用数据内部时空相关性和外部关联信息来提高吞吐量的恢复精度成为了关键.为此,本文提出了基于关联学习的张量填充模型.首先将由往返时延和关联学习模型推测出来的吞吐量张量𝒳 ' 𝒳 𝒳 ˜

𝒳 ˜ = P Ω ( 𝒳 ) + P Ω ¯ ( 𝒳 ' ) (6)

其中,P Ω Ω ( i , j , k ) ∈ Ω P Ω ( 𝒳 ) i j k = x i j k P Ω ( 𝒳 ) i j k = 0 . P Ω ¯ 式(6)中,预填充的吞吐量张量保留了原始吞吐量张量的测量值,仅使用关联学习模型对缺失点的推测值,即当( i , j , k ) ∈ Ω x ˜ i j k = x i j k ( i , j , k ) ∈ Ω ¯ x ˜ i j k = x i j k ' .

为了挖掘吞吐量测量数据内部的潜在特征,使用CP分解将预填充的吞吐量张量𝒳 ˜ A ∈ R I × R B ∈ R J × R C ∈ R K × R 𝒳 ˜ ≈ A , B , C R a i ∈ R 1 × R b j ∈ R 1 × R c k ∈ R 1 × R A i B j C k i j k R 1 × R 𝒳 ˜ x ˜ i j k ≈ a i ⋅ b j ⋅ c k = ∑ r = 1 R a i r b j r c k r .

在基于CP分解的张量填充算法中,网络数据恢复问题被转换为张量填充问题,训练潜在因子向量a i b j c k 式(7)所示.对于每一个源节点-目的节点-时间三元组,式(7)基于源节点潜在特征因子、目的节点潜在因子和时间潜在因子之间的交互来建模吞吐量的值.

m i n a i , b j , c k 1 | Ω | ∑ ( i , j , k ) ∈ Ω x ˜ i j k - a i ⋅ b j ⋅ c k 2 (7)

然而,传统CP分解模型仅使用测量点的数据进行训练,无法有效地利用往返时延及其与吞吐量之间的关联.本文提出了一个组合的加权损失函数,在原有的目标函数中加入了往返时延的辅助信息.所提损失函数如式(8)所示,其中ρ ( i , j , k ) ( i , j , k ) ∈ Ω ρ ( i , j , k ) = 1 ( i , j , k ) ∈ Ω ¯ ρ ( i , j , k ) = λ λ ∈ ( 0,1 )

m i n a i , b j , c k 1 | Ω | + | Ω ¯ | ∑ ( i , j , k ) ∈ Ω ⋃ Ω ¯ ρ ( i , j , k ) x ˜ i j k - a i ⋅ b j ⋅ c k 2 (8)

式(8)整体上利用CP分解因子向量a i b j c k

图6 为所提框架求解张量填充问题的主要步骤,包括:(1)组合测量张量与推测张量获得预填充张量;(2)基于CP分解,使用测量样本和推测样本同时训练潜在因子向量;(3)使用训练好的潜在因子向量估计张量元素.在获得了3个因子矩阵A B C 𝒳 ̂ = A , B , C x ̂ i j k = a i ⋅ b j ⋅ c k = ∑ r = 1 R a i r b j r c k r .

图6

4.4 详细算法流程

算法1 总结了基于关联学习的张量填充算法的完整流程,其中超参数的设置将在实验部分详细说明.在读取数据之后,首先训练吞吐量-往返时延关联学习模型,获得通过关联推测的吞吐量张量.再预填充吞吐量张量,训练基于关联学习的张量填充模型,最后计算吞吐量的估计值.

5 实验评估

5.1 实验设置

数据集 为了评估所提算法的性能,本文在WS-DREAM数据集上执行了大量对比实验,将其建模成大小为142×4 500×64的吞吐量张量和往返时延张量.原始数据集中,吞吐量的数据点占比为62.72%,往返时延的数据点占比为73.79%.仿真实验中,吞吐量张量的所有数据点按照p ∶p ∶1-2p 的比例被划分为训练集、验证集和测试集,其中p ∈

评价指标 本文使用2个评价指标来评估数据恢复的准确性,分别是归一化的平均绝对误差(Normalized Mean Absolute Error,NMAE)和归一化的均方根误差(Normalized Root Mean Square Error,NRMSE),计算方式分别如式(9)和式(10)所示.

N M A E = ∑ ( i , j , k ) ∈ Ω ¯ | x i j k - x ̂ i j k | ∑ ( i , j , k ) ∈ Ω ¯ | x i j k | (9)

N R M S E = ∑ ( i , j , k ) ∈ Ω ¯ ( x i j k - x ̂ i j k ) 2 ∑ ( i , j , k ) ∈ Ω ¯ ( x i j k ) 2 (10)

所有的实验结果都报告在测试集上,式(9)和式(10)中缺失样本索引集合Ω ¯ x i j k x ̂ i j k

实验条件 所提模型部署在Pytorch上,使用NVIDIA GPU,GeForce RTX 2060上运行的CUDA 10.1对训练过程进行加速、Adam小批量梯度下降算法对模型进行优化,ALM的批大小设置为128,ALTC的批大小为1 024,学习率都为10-4 .实验中设置了2个迭代停止条件,满足其一即可:(1)达到最大迭代次数1 000;(2)验证集上的损失函数连续50轮没有下降.

对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] .

5.2 与传统线性算法对比恢复性能

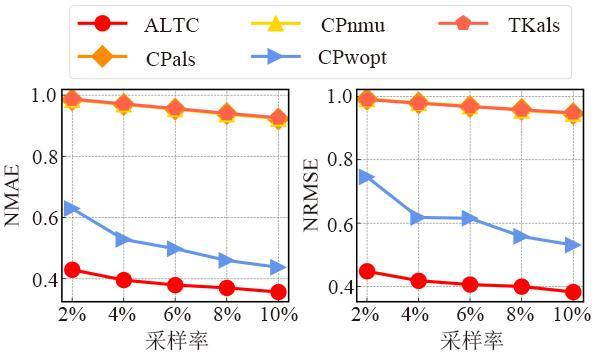

图7 绘制了ALTC与4种传统线性张量填充算法在不同采样率下缺失数据的恢复误差曲线.随着采样率的增加,测量样本的增加,所有算法的恢复性能都随着NMAE和NRMSE的减少而增加.在所有的采样率下,ALTC以更小的NMAE和NRMSE达到了更好的恢复性能.即使在数据非常稀疏(采样率2%)的情况下,ALTC的NMAE和NRMSE约为0.43和0.45,而传统线性算法(CPwopt)的NMAE和NRMSE约为0.64和0.76,分别是ALTC的1.5倍和1.7倍.这些结果表明,ALTC能够有效地挖掘并利用多指标的辅助信息,达到更好的恢复性能.

图7

图7

ALTC在不同采样率下与传统线性算法对比恢复性能

5.3 与神经网络算法对比恢复性能

表1 、表2 记录了ALTC与4种神经网络张量填充算法在不同采样率下的缺失数据的恢复性能,其中表1 为NMAE,表2 为NRMSE.如表所示,所有算法的恢复性能都随着采样率的增加变得更好,表现为越来越小的NMAE和NRMSE.对比其他算法,ALTC在当前采样率和评价指标下都达到了更低的恢复误差,说明在相同的吞吐量测量代价下,ALTC的恢复效果更好.在采样率2%的情况下,ALTC比目前主流的神经网络填充结果改进了( 0.493 1 - 0.429 0 ) / 0.493 1 ≈ 13 %的NMAE以及( 0.528 6 - 0.447 8 ) / 0.528 6 ≈ 15 %的NRMSE.这进一步证实了所提算法的有效性,即使ALTC是基于CP分解架构的线性填充算法,训练参数也远小于复杂的神经网络模型,但由于很好地利用了多指标辅助信息,表现出了优异的性能.

5.4 吞吐量- 往返时延关联学习模型分析

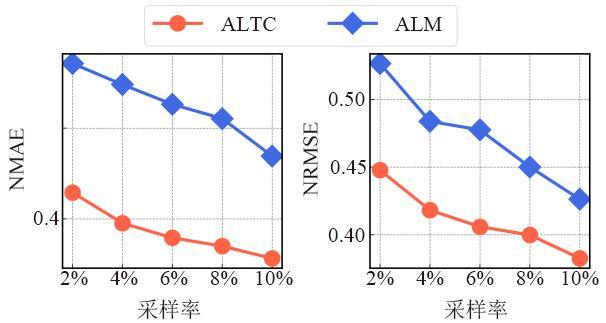

图8 给出了仅使用关联学习模型ALM通过往返时延推测吞吐量在不同吞吐量采样率下的推测效果.为了更直观地展示,同样绘制了ALTC的恢复性能用于对比.通过图8 可以观察到,ALTC比ALM对于吞吐量指标的估计效果更好,因为ALTC是在ALM架构上的改进,验证了所提的基于关联学习的张量填充的有效性.对比表1 、表2 与图8 中的结果,可以发现ALM与目前主流的神经网络张量填充算法相比仍然取得了非常有竞争力的性能,这表明了本文所提的关联学习模型在挖掘吞吐量-往返时延关联上的优越性.

图8

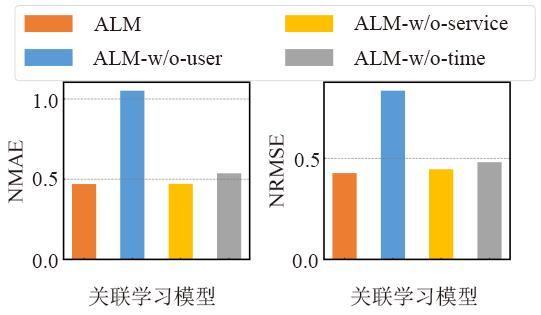

如4.2节所示,为了考虑上下文信息,关联学习模型输入为张量3个维度的纤维,对应于时间维度的变化以及不同源节点(用户)、目的节点(服务)类型的影响.为了研究最终的吞吐量值与不同上下文信息的关联性强度,固定采样率为10%,在图9 给出了考虑不同上下文信息的关联学习模型的推测效果.图9 中,ALM为原始模型,同时考虑了3个维度的上下文信息,其他3个模型是ALM的变种:ALM-w/o-time表示在输入时去掉时间纤维,仅考虑不同节点类型的影响;ALM-w/o-user表示在输入时去掉用户纤维,仅考虑不同服务节点类型和时间变化的影响;ALM-w/o-service表示在输入时去掉服务纤维,仅考虑不同用户节点类型和时间变化的影响.可以观察到,在四个模型中,ALM的误差最小,说明三个维度的上下文信息对推测吞吐量的值都非常有效;ALM-w/o-user的误差最大,说明考虑不同的用户节点类型对恢复效果的收益最大,即不同的用户节点类型与最终的吞吐量预测值最相关.

图9

5.5 超参数研究

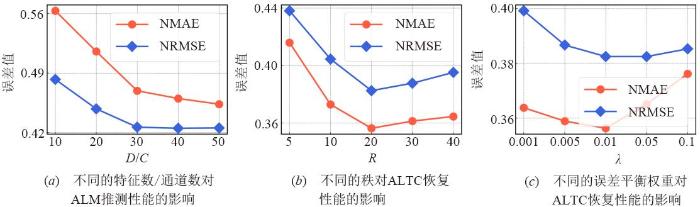

本节描述了关键超参数(ALM的特征数D C R λ

特征数 D 、通道数 C 的影响 特征数D C D C 图10 (a )绘制不同特征数和通道数对ALM推测性能的影响.随着D C D C D = C = 30 .

图10

张量秩 R 的影响 张量秩R R 图10 (b )绘制了不同的秩对ALTC恢复性能的影响.一开始随着R R 20 R R R = 20 .

误差平衡权重 λ 的影响 如式(8)所示,损失函数中的λ λ λ 图10 (c )绘制了不同的误差平衡权重对模型恢复性能的影响.一开始随着λ λ 0.01 λ λ λ = 0.01 .

5.6 复杂度分析

如算法1 所示,本文提出的模型可以分为独立的两个训练步骤:ALM和ALTC.由于ALTC是基于CP分解架构的线性填充算法,相比于传统的线性张量填充算法,仅需要额外的开销用于训练ALM,其训练参数集合Θ ( I + J + K + C + 3 ) D + 4 C + 1 . 表3 给出了采样率10%下不同模型的训练时间.ALM训练一批数据的时间最长,即单位训练时间最长,因为需要更多的时间学习从往返时延到吞吐量复杂的映射关系,而且在实际应用中,可以用历史数据事先将ALM训练好,在数据恢复时直接使用,大大加快填充速度.ALTC训练一轮全部数据需要的时间比CP分解需要的时间更长,即全部训练时间最长,因为训练数据更多,当采样率为10%时,CP分解只有10%的吞吐量测量值用于训练,而ALTC有10%的吞吐量测量值和90%的吞吐量推测值用于训练,是CP分解的10倍.

6 结论

本文提出了一种新的面向大规模网络测量的数据恢复算法,即基于关联学习的张量填充(ALTC),针对网络监控系统难以获得全网吞吐量测量数据的问题,利用吞吐量内部的时空相关性和外部指标的关联,以低测量代价获取全部吞吐量数据.首先研究网络性能指标的实际关联,设计了吞吐量-往返时延关联学习模型,使用低开销的往返时延推测高开销的吞吐量,降低测量代价.为了利用多指标关联模型辅助吞吐量填充,提高数据恢复的精度,进一步将吞吐量的测量值与通过往返时延和关联学习模型的推测值合并为新的张量填充拟合目标,并设计新的张量填充模型,同时学习吞吐量测量值和来自于往返时延的推测值的信息,设置误差平衡参数平衡两部分误差的权重.真实数据集的实验结果表明在相同的吞吐量测量代价下,本文所提的数据恢复算法ALTC的恢复误差在传统线性张量填充算法的结果上改善了1.5倍,而且比目前主流的神经网络张量填充算法的恢复结果降低了13%的误差.

参考文献

View Option

[1]

CUNHA I TEIXEIRA R VEITCH D et al Predicting and tracking internet path changes

[C]//Proceedings of the ACM SIGCOMM 2011 Conference . New York : ACM , 2011 : 122 -133 .

[本文引用: 1]

[2]

JAIN S KUMAR A MANDAL S et al . B 4 : Experience with a globally-deployed software defined wan

[C]//SIGCOMM'13: Proceedings of the ACM SIGCOMM 2013 conference on SIGCOMM . New York : ACM , 2013: 3 -14 .

[3]

PENG Y H YANG J WU C et al deTector: A topology-aware monitoring system for data center networks

[C]//Proceedings of the 2017 USENIX Annual Technical Conference . Santa Clara : USENIX Association , 2017 : 55 -68 .

[本文引用: 1]

[4]

MATHIS M ALLMAN M A Framework for Defining Empirical Bulk Transfer Capacity Metrics

[R]. United States : RFC Editor , 2001 .

[本文引用: 1]

[5]

曾彬 基于主动测试的网络性能监测技术研究

[D]. 长沙 : 湖南大学 , 2009 .

[本文引用: 1]

ZENG B Researches on Internet Performance Monitoring Based on Active Measurements

[D]. Changsha : Hunan University , 2009 . (in Chinese)

[本文引用: 1]

[6]

BREITBART Y CHAN C-Y GAROFALAKIS M et al Efficiently monitoring bandwidth and latency in IP networks

[C]//Proceedings IEEE INFOCOM 2001, Conference on Computer Communications, Twentieth Annual Joint Conference of the IEEE Computer and Communications Society(Cat . No .01 CH37213 . Anchorage, AK: IEEE , 2001: 933 -942 .

[本文引用: 1]

[7]

CLAISE B SADASIVAN G VALLURI V et al Cisco systems netflow services export version

9 , RFC 3954[EB/OL]. (2004-10 )[2022-04-05 ]. .

[本文引用: 1]

[8]

TOOTOONCHIAN A GHOBADI M GANJALI Y OpenTM: Traffic matrix estimator for OpenFlow networks

[C]//International Conference on Passive and Active Network Measurement . Berlin, Heidelberg : Springer , 2010 : 201 -210 .

[本文引用: 1]

[9]

GUO C X YUAN L H XIANG D et al Pingmesh: A large-scale system for data center network latency measurement and analysis

[C]//SIGCOMM'15: Proceedings of the 2015 ACM Conference on Special Interest Group on Data Communication . London : ACM , 2015 : 139 -152 .

[本文引用: 1]

[10]

XIE K WANG L L WANG X et al Sequential and adaptive sampling for matrix completion in network monitoring systems

[C]//2015 IEEE Conference on Computer Communications . Hong Kong : IEEE , 2015 : 2443 -2451 .

[本文引用: 1]

[11]

KONG L H XIA M Y LIU X Y et al Data loss and reconstruction in sensor networks

[C]//2013 Proceedings of IEEE International Conference on Computer Communications . Turin : IEEE , 2013 : 1654 -1662 .

[本文引用: 1]

[12]

ZHANG Y ROUGHAN M WILLINGER W et al Spatio-temporal compressive sensing and Internet traffic matrices

[J]. ACM SIGCOMM Computer Communication Review , 2009 , 39 (4 ): 267 -278 .

[本文引用: 1]

[13]

KORTAS M HABACHI O BOUALLEGUE A et al Robust data recovery in wireless sensor network: A learning-based matrix completion framework

[J]. Sensors(Basel) , 2021 , 21 (3 ): 1016 .

[本文引用: 1]

[14]

XIE K CHEN Y X WANG X et al Accurate and fast recovery of network monitoring data: A GPU accelerated matrix completion

[J]. IEEE/ACM Transactions on Networking , 2020 , 28 (3 ): 958 -971 .

[本文引用: 1]

[15]

XIE K WANG X G WANG X et al Accurate recovery of missing network measurement data with localized tensor completion

[J]. IEEE/ACM Transactions on Networking , 2019 , 27 (6 ): 2222 -2235 .

[本文引用: 2]

[16]

DENG L ZHENG H F LIU X Y et al Network latency estimation with leverage sampling for personal devices: An adaptive tensor completion approach

[J]. IEEE/ACM Transactions on Networking , 2020 , 28 (6 ): 2797 -2808 .

[本文引用: 1]

[17]

WANG Q Q CHEN L WANG Q et al Anomaly-aware network traffic estimation via outlier-robust tensor completion

[J]. IEEE Transactions on Network and Service Management , 2020 , 17 (4 ): 2677 -2689 .

[本文引用: 1]

[18]

XIE K LI S Q WANG X et al Expectile tensor completion to recover skewed network monitoring data

[C]//IEEE INFOCOM 2021-IEEE Conference on Computer Communications . Vancouver : IEEE , 2021 : 1 -10 .

[本文引用: 1]

[19]

XIE K LU H L WANG X et al Neural tensor completion for accurate network monitoring

[C]//IEEE INFOCOM 2020-IEEE Conference on Computer Communications . Toronto : IEEE , 2020 : 1688 -1697 .

[本文引用: 3]

[20]

CARROLL J D CHANG J J Analysis of individual differences in multidimensional scaling via an n-way generalization of “Eckart-Young” decomposition

[J]. Psychometrika , 1970 , 35 (3 ): 283 -319 .

[本文引用: 1]

[21]

HARSHMAN R A Foundations of the PARAFAC procedure: Models and conditions for an “explanatory” multimodal factor analysis

[J]. UCLA Working Papers in Phonetics , 1970 . 16 : 1 -84 .

[本文引用: 1]

[22]

TUCKER L R Some mathematical notes on three-mode factor analysis

[J]. Psychometrika , 1966 , 31 (3 ): 279 -311 .

[本文引用: 1]

[23]

ZHENG Z B LYU M R WS-DREAM: A distributed reliability assessment mechanism for web services

[C]//2008 IEEE International Conference on Dependable Systems and Networks With FTCS and DCC . Anchorage : IEEE , 2008 : 392 -397 .

[本文引用: 1]

[24]

张贤达 矩阵分析与应用 [M]. 北京 : 清华大学出版社 , 2008 .

[本文引用: 1]

ZHANG X D Matrix Analysis and Applications [M]. Beijing : Tsinghua University Press , 2008 . (in Chinese)

[本文引用: 1]

[25]

BADER B W KOLDA T G Tensor toolbox for MATLAB, version 3.2.

1[EB/OL]. (2021-04-05 )[2022-04-05 ]. .

[本文引用: 2]

[26]

WEN Z W YIN W T ZHANG Y Solving a low-rank factorization model for matrix completion by a nonlinear successive over-relaxation algorithm

[J]. Mathematical Programming Computation , 2012 , 4 (4 ): 333 -361 .

[本文引用: 1]

[27]

ACAR E DUNLAVY D M KOLDA T G et al Scalable tensor factorizations for incomplete data

[J]. Chemometrics and Intelligent Laboratory Systems , 2011 , 106 (1 ): 41 -56 .

[本文引用: 1]

[28]

WU X SHI B X DONG Y X et al Neural tensor factorization for temporal interaction learning

[C]//WSDM'19: Proceedings of the Twelfth ACM International Conference on Web Search and Data Mining . Melbourne : ACM , 2019 : 537 -545 .

[本文引用: 1]

[29]

CHEN H Y LI J Neural tensor model for learning multi-aspect factors in recommender systems

[C]//Proceedings of the Twenty-Ninth International Joint Conference on Artificial Intelligence . Yokohama : International Joint Conferences on Artificial Intelligence Organization , 2020 : 2449 -2455 .

[本文引用: 1]

[30]

LIU H P LI Y G TSANG M et al CoSTCo: A neural tensor completion model for sparse tensors

[C]//KDD'19 Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining . Anchorage : ACM , 2019 : 324 -334 .

[本文引用: 1]

Predicting and tracking internet path changes

1

2011

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

Experience with a globally-deployed software defined wan

0

4

deTector: A topology-aware monitoring system for data center networks

1

2017

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

A Framework for Defining Empirical Bulk Transfer Capacity Metrics

1

2001

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

基于主动测试的网络性能监测技术研究

1

2009

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

基于主动测试的网络性能监测技术研究

1

2009

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

Efficiently monitoring bandwidth and latency in IP networks

1

01

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

Cisco systems netflow services export version

1

9

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

OpenTM: Traffic matrix estimator for OpenFlow networks

1

2010

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

Pingmesh: A large-scale system for data center network latency measurement and analysis

1

2015

... 网络吞吐量记录了端到端网络成功传输数据的速率,是衡量网络性能的重要指标.获取全网端到端吞吐量对于了解网络状态、跟踪服务等级协议和定位网络故障等应用[1 ~3 ] 至关重要.然而,由于测量代价大,现有的网络监控系统难以获得完整准确的全网吞吐量测量值.本文中吞吐量定义为单位时间内端到端网络源节点成功向目的节点传输的实际数据量,不包括包头,并且重传的数据包只计算一次[4 ] .测量网络吞吐量通常需要从源端向目的端传输一个大的文件,并测量完成文件传输所需要的时间,再将文件大小除以传输时间来计算吞吐量[5 ] .这种方法会产生大量测试流量,影响网络性能.一些数据包流级别的直接测量技术[6 ,7 ] 通过跟踪经过设备的数据包将具有相同源-目的地址的数据包汇聚成一个流作为该源-目的地址之间的流量即吞吐量,这种方法可以做到准确测量,不会被背景流量干扰.但是由于缺乏支持设备以及测量开销等原因,直接测量只能够测量部分源-目的地址之间的吞吐量[8 ] .尽管现在已经有成熟的网络监控系统可以实时测量网络时延,比如微软Pingmesh[9 ] 通过发送探测数据包能够测量大规模数据中心网络中任意两个服务器之间任何时刻的时延,获取每对节点之间任意时刻的吞吐量测量值仍然很困难. ...

Sequential and adaptive sampling for matrix completion in network monitoring systems

1

2015

... 近年来,有研究表明端到端网络性能数据具有隐藏的时空相关性[10 ] ,提出了稀疏网络测量技术.稀疏网络测量技术基于采样的方式降低测量代价,仅测量部分路径和时隙的数据,推测全部数据,将网络测量问题转换成从部分测量值估计全部测量值的数据恢复问题.目前主要有3种典型的稀疏重构技术:压缩传感、矩阵填充和张量填充.作为一维向量和二维矩阵的高阶推广,张量模型可以充分利用多线性结构,挖掘高维数据之间隐藏的内在联系,达到更好的数据恢复精度.尽管前景光明,现有的张量填充算法针对网络性能数据恢复的研究现状仍然具有很大局限性,具体表现在其算法只考虑了单个网络性能指标的数据恢复,忽略了多个网络测量指标的关联信息. ...

Data loss and reconstruction in sensor networks

1

2013

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

Spatio-temporal compressive sensing and Internet traffic matrices

1

2009

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

Robust data recovery in wireless sensor network: A learning-based matrix completion framework

1

2021

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

Accurate and fast recovery of network monitoring data: A GPU accelerated matrix completion

1

2020

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

Accurate recovery of missing network measurement data with localized tensor completion

2

2019

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

... 近年来有大量基于张量填充的网络数据恢复研究.Xie等人[15 ] 寻找数据的更强局部相关性来形成和填充更低秩的子张量,恢复网络流量数据.Deng等人[16 ] 提出了一种基于杠杆分数采样的自适应张量填充方案估计个人设备网络的延迟数据.Wang等人[17 ] 考虑网络数据中的噪声和异常,将L 2,1 范数和LF 范数引入张量填充模型中,估计网络流量.Xie等人[18 ] 基于Expectile回归对张量填充不同数据点的拟合误差设置两种不同的权重,提高大象流的恢复精度.除了这些基于CP分解或者Tucker分解的线性张量填充模型,Xie等人[19 ] 使用神经网络模型扩展传统张量填充算法的交互函数恢复网络监测数据,取得了很好的恢复精度. ...

Network latency estimation with leverage sampling for personal devices: An adaptive tensor completion approach

1

2020

... 近年来有大量基于张量填充的网络数据恢复研究.Xie等人[15 ] 寻找数据的更强局部相关性来形成和填充更低秩的子张量,恢复网络流量数据.Deng等人[16 ] 提出了一种基于杠杆分数采样的自适应张量填充方案估计个人设备网络的延迟数据.Wang等人[17 ] 考虑网络数据中的噪声和异常,将L 2,1 范数和LF 范数引入张量填充模型中,估计网络流量.Xie等人[18 ] 基于Expectile回归对张量填充不同数据点的拟合误差设置两种不同的权重,提高大象流的恢复精度.除了这些基于CP分解或者Tucker分解的线性张量填充模型,Xie等人[19 ] 使用神经网络模型扩展传统张量填充算法的交互函数恢复网络监测数据,取得了很好的恢复精度. ...

Anomaly-aware network traffic estimation via outlier-robust tensor completion

1

2020

... 近年来有大量基于张量填充的网络数据恢复研究.Xie等人[15 ] 寻找数据的更强局部相关性来形成和填充更低秩的子张量,恢复网络流量数据.Deng等人[16 ] 提出了一种基于杠杆分数采样的自适应张量填充方案估计个人设备网络的延迟数据.Wang等人[17 ] 考虑网络数据中的噪声和异常,将L 2,1 范数和LF 范数引入张量填充模型中,估计网络流量.Xie等人[18 ] 基于Expectile回归对张量填充不同数据点的拟合误差设置两种不同的权重,提高大象流的恢复精度.除了这些基于CP分解或者Tucker分解的线性张量填充模型,Xie等人[19 ] 使用神经网络模型扩展传统张量填充算法的交互函数恢复网络监测数据,取得了很好的恢复精度. ...

Expectile tensor completion to recover skewed network monitoring data

1

2021

... 近年来有大量基于张量填充的网络数据恢复研究.Xie等人[15 ] 寻找数据的更强局部相关性来形成和填充更低秩的子张量,恢复网络流量数据.Deng等人[16 ] 提出了一种基于杠杆分数采样的自适应张量填充方案估计个人设备网络的延迟数据.Wang等人[17 ] 考虑网络数据中的噪声和异常,将L 2,1 范数和LF 范数引入张量填充模型中,估计网络流量.Xie等人[18 ] 基于Expectile回归对张量填充不同数据点的拟合误差设置两种不同的权重,提高大象流的恢复精度.除了这些基于CP分解或者Tucker分解的线性张量填充模型,Xie等人[19 ] 使用神经网络模型扩展传统张量填充算法的交互函数恢复网络监测数据,取得了很好的恢复精度. ...

Neural tensor completion for accurate network monitoring

3

2020

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

... 近年来有大量基于张量填充的网络数据恢复研究.Xie等人[15 ] 寻找数据的更强局部相关性来形成和填充更低秩的子张量,恢复网络流量数据.Deng等人[16 ] 提出了一种基于杠杆分数采样的自适应张量填充方案估计个人设备网络的延迟数据.Wang等人[17 ] 考虑网络数据中的噪声和异常,将L 2,1 范数和LF 范数引入张量填充模型中,估计网络流量.Xie等人[18 ] 基于Expectile回归对张量填充不同数据点的拟合误差设置两种不同的权重,提高大象流的恢复精度.除了这些基于CP分解或者Tucker分解的线性张量填充模型,Xie等人[19 ] 使用神经网络模型扩展传统张量填充算法的交互函数恢复网络监测数据,取得了很好的恢复精度. ...

... 对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...

Analysis of individual differences in multidimensional scaling via an n-way generalization of “Eckart-Young” decomposition

1

1970

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

Foundations of the PARAFAC procedure: Models and conditions for an “explanatory” multimodal factor analysis

1

1970

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

Some mathematical notes on three-mode factor analysis

1

1966

... 从网络性能数据的部分测量值恢复未测量的缺失数据依赖于稀疏网络测量技术.最开始的压缩传感技术使用单纯的空间或时间信息重构缺失数据[11 ,12 ] .由于压缩传感主要作用于一维向量数据,应用范围受限,发展了矩阵填充技术使用简单的时空信息从低秩矩阵中恢复缺失数据[13 ,14 ] .然而,二维矩阵的形式在捕获数据潜在相关性上的作用仍然很有限,当数据缺失率较高时,恢复性能会受很大影响.为了克服基于矩阵方法的不足,一些新的研究基于张量填充技术,利用张量的多线性结构捕获网络测量数据更丰富的时空信息达到更精确的恢复效果[15 ~19 ] .张量填充算法依赖于张量分解,使用最广泛的张量分解模型有CANDECOMP/PARAFAC(CP)分解[20 ,21 ] 和Tucker分解[22 ] ,其他模型都是对这两个模型的改进. ...

WS-DREAM: A distributed reliability assessment mechanism for web services

1

2008

... 为了研究吞吐量与往返时间之间的关联模型,本文首先对真实网络数据集进行实验验证,分析吞吐量与往返时延之间的关联.WS-DREAM[23 ] 数据集记录了142个用户在64个连续时间片(以15分钟为间隔)上的4 500个Web服务的服务质量测量结果,包括了吞吐量和往返时延.随机选取了数据集中的若干个源目的(即用户-服务)节点对,并绘制了其中4组源目的节点对沿着64个时间片的测量值大小.如图4 所示,横坐标为时间片的索引,纵坐标为测量值的大小,0轴的上方为吞吐量大小,0轴的下方为往返时延大小.图片显示当吞吐量持平时,往返时延也相对稳定;当吞吐量较大时,往返时延相对较小;当吞吐量较小时,往返时延相对较大.尤其当吞吐量极小时,往返时延很大,可能是由于发生了拥塞. ...

1

2008

... 在张量建模下,对于往返时延张量𝒴 y i j k i j k y : j k ∈ R I × 1 y i : k ∈ R J × 1 y i j : ∈ R K × 1 [24 ] .这3个向量在张量𝒴 y i j k y : j k y i : k y i j :

1

2008

... 在张量建模下,对于往返时延张量𝒴 y i j k i j k y : j k ∈ R I × 1 y i : k ∈ R J × 1 y i j : ∈ R K × 1 [24 ] .这3个向量在张量𝒴 y i j k y : j k y i : k y i j :

Tensor toolbox for MATLAB, version 3.2.

2

... 对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...

... [25 ],前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...

Solving a low-rank factorization model for matrix completion by a nonlinear successive over-relaxation algorithm

1

2012

... 对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...

Scalable tensor factorizations for incomplete data

1

2011

... 对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...

Neural tensor factorization for temporal interaction learning

1

2019

... 对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...

Neural tensor model for learning multi-aspect factors in recommender systems

1

2020

... 对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...

CoSTCo: A neural tensor completion model for sparse tensors

1

2019

... 对比算法 对比算法覆盖了传统的线性张量填充算法,包括CPals[25 ] 、CPnmu[26 ] 、CPwopt[27 ] 、TKals[25 ] ,前3个算法基于CP分解,最后一个算法基于Tucker分解;以及目前主流的神经网络张量填充算法,包括NTC[19 ] 、NTF[28 ] 、NTM[29 ] 、CoSTCo[30 ] . ...